Der dichteste Dschungel

Das Konnektom bezeichnet die Gesamtheit aller Nervenzellen und Verknüpfungen im Gehirn. Mit hochauflösenden Elektronenmikroskopen und künstlicher Intelligenz versuchen Forscher schrittweise, die Hirnarchitektur darzustellen, um mehr über die Funktionsweise des Organs zu lernen.

Veröffentlicht: 30.04.2021

Niveau: leicht

Moritz Helmstaedter ist Direktor und Wissenschaftliches Mitglied am Max-Planck-Institut für Hirnforschung in Frankfurt und Professor für Neuronale Netzwerke an der Radboud Universität in Nijmegen, Holland. Für seine Arbeiten wurde er unter anderem mit der Otto-Hahn-Medaille und der Bernard Katz Lecture geehrt.

Empfohlene Artikel

Herr Helmstaedter, als Hirnforscher können Sie mir bestimmt anschaulich erklären, wie es in unserem Kopf aussieht.

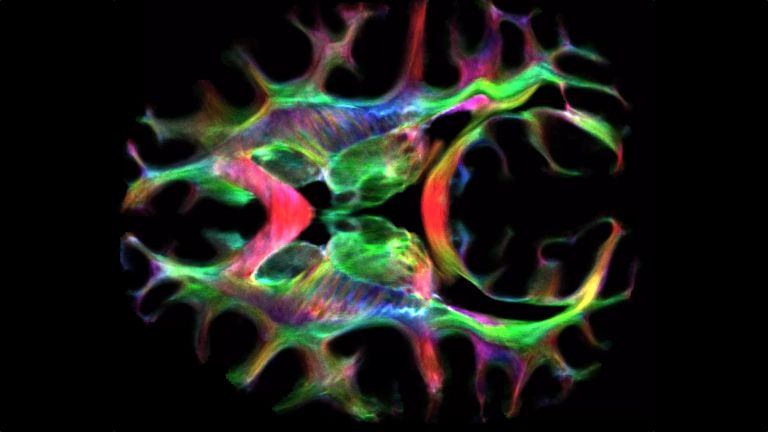

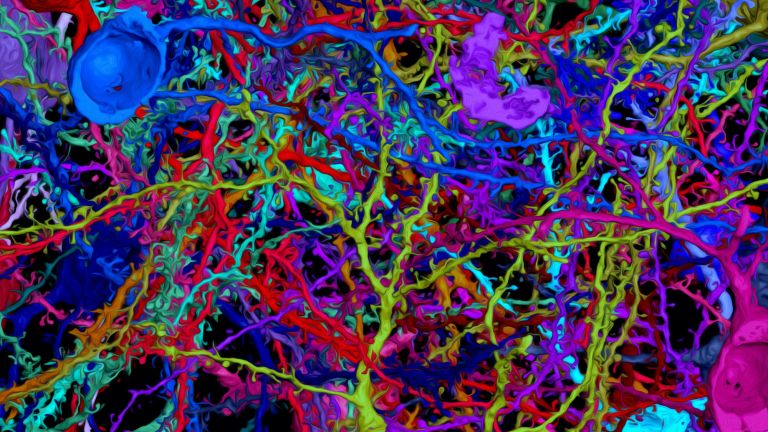

Man kann sich im Prinzip ein wahnsinnig dichtes Kabelgewirr vorstellen, viel verworrener als hinter Ihrer Stereoanlage: die Packungsdichte im Gehirn ist um ein Vielfaches größer. Bei den „Kabeln“ handelt es sich um die Nervenfortsätze der Neuronen. Von diesen Zellen gibt es im Gehirn etwa 86 Milliarden. Jede einzelne davon ist mit ungefähr Tausend anderen über Kontaktstellen an den Kabeln, den Synapsen, verbunden. Die Kabel sind also zum einen hochverzweigt und zum anderen ziemlich lang. Würde man sie ausrollen, würden sie mehrere Zentimeter messen. Damit sind sie bis zu zehntausendmal länger als der Durchmesser des Zellkörpers. Gleichzeitig sind die Kabel aber extrem fein, circa tausendmal dünner als ein Haar.

Also vermitteln schematische Abbildungen von Neuronennetzwerken ein falsches Bild?

Notwendigerweise sind solche Darstellungen sehr vereinfacht und ausgedünnt, weil man sonst eigentlich gar nichts sehen würde. Aber Nervenzellen im freien Raum – so etwas gibt es nicht. Es existiert kein dichterer „Dschungel“ als der im Gehirn. Und das Besondere daran ist, dass die Nervenzellen über diesen Kabeldschungel kommunizieren können. Es findet eine sehr komplexe Interaktion statt, oft zwischen ganz unterschiedlichen Hirnbereichen.

Wie gelingt es, die von Ihnen beschriebene Architektur nachzuvollziehen?

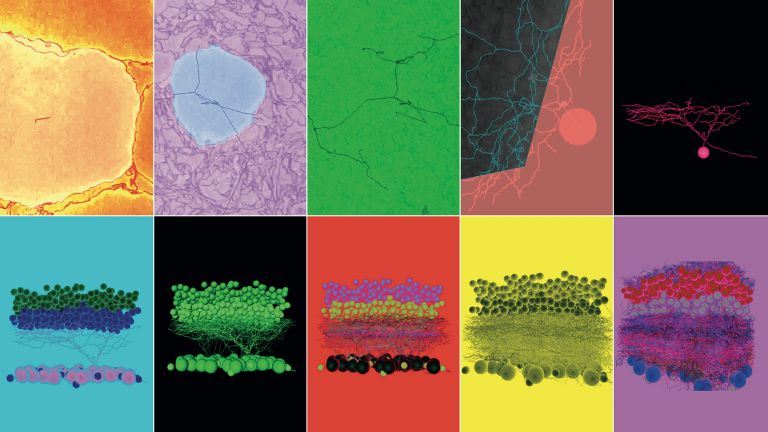

Die letzten hundert Jahre hat man sich die Nervenzellen vor allem mit Lichtmikroskopen angeschaut. Die Nervenzellnetzwerke lassen sich damit jedoch nicht komplett im Detail auflösen. Heutzutage nutzen wir hochauflösende Elektronenmikroskope, mit denen wir auch noch die dünnsten Nervenzellfortsätze darstellen können und gleichzeitig über große Distanzen Bilddaten aufnehmen. Es reicht nämlich nicht, nur einzelne Bilder zu machen, stattdessen brauchen wir Zehn- oder gar Hunderttausende, um den dünnen Kabeln über erhebliche Strecken folgen zu können.

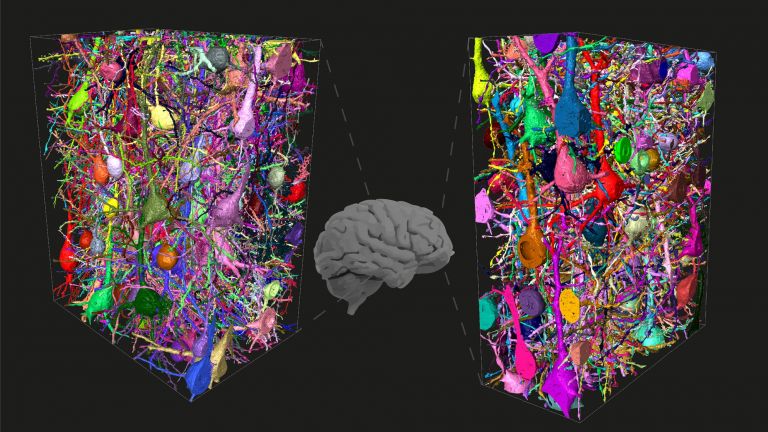

Also dreidimensionale Bilddatensätze?

Richtig. Die bekommen wir, indem wir nacheinander einzelne Bilder machen und diese am Ende zusammensetzen. Dazu schaben wir nach jeder Aufnahme eine ganz dünne Schicht des Hirngewebes ab – nur rund 25 Nanometer dick. Bedeutet: Aufnahme, Abschaben, Aufnahme und so weiter. Das ist die so genannte blockbasierte Variante. Man kann allerdings auch ein Stück Hirngewebe zunächst in hauchdünne Scheiben schneiden, aufkleben und dann nacheinander Bilder davon aufnehmen. Bei beiden Methoden werden dann die einzelnen Aufnahmen zu einem dreidimensionalen Bilddatensatz zusammengesetzt.

Wie groß sind die Gewebeblöcke denn in der Regel?

Angefangen haben wir vor rund 20 Jahren mit Blöcken in der Größenordnung von einem Zehntel Millimeter Kantenlänge, also nicht größer als ein ziemlich kleines Sandkorn. Mittlerweile sind wir bei einer Kantenlänge von etwa einem halben Millimeter. Das große nächste Ziel sind reiskorngroße Blöcke mit Kantenlängen im Millimeterbereich.

Wie lange dauert eine solche Aufnahme?

Typischerweise mehrere Monate. Und dann beginnt die Datenanalyse, die nochmal viel länger dauert. Das kann sich über Jahre hinziehen.

Weshalb ist das so langwierig?

Die große Herausforderung ist es, den Kabeln der Nervenzellen in diesem unglaublichen Dickicht zu folgen. Mit Hilfe von künstlicher Intelligenz (KI) versuchen wir, das Stück für Stück zu rekonstruieren und alles korrekt zusammenzusetzen. An Problemstellen müssen bisher jedoch immer wieder Menschen nachprüfen und Entscheidungen treffen – dazu haben wir Hunderte von Studenten, die dann am Bildschirm gewissermaßen einen Flug durch das Hirngewebe machen und den Kabeln folgen. Die Synapsen hingegen erkennt die KI bereits eigenständig ziemlich zuverlässig. So wissen wir, welche Zellen miteinander verknüpft sind.

Ziel ist es dann, aus diesen Einzelstücken gewissermaßen das gesamte Gehirn zusammenzusetzen?

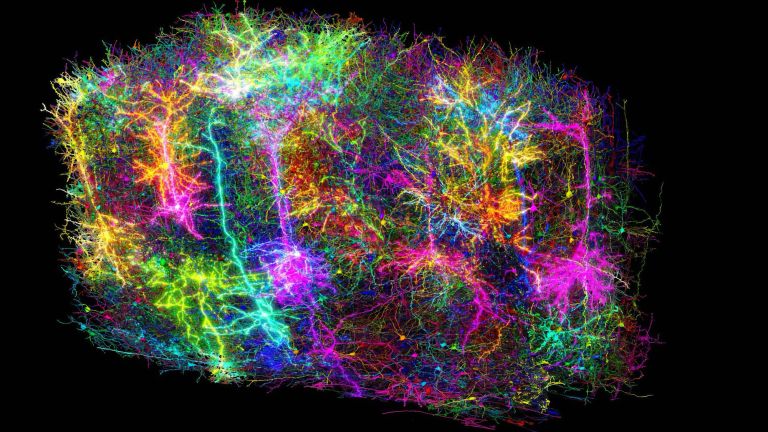

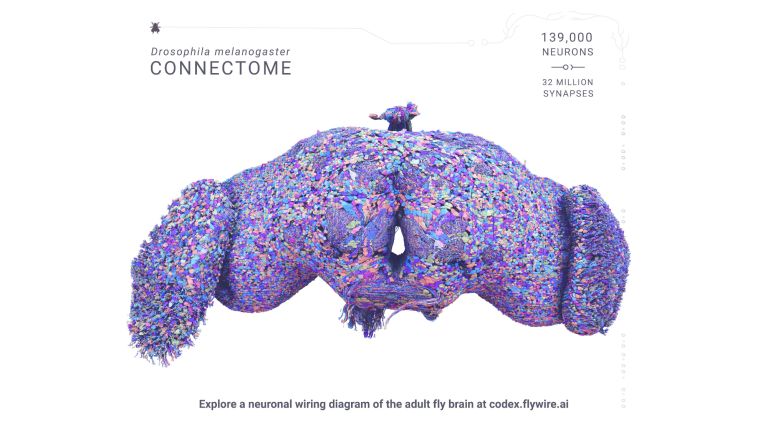

Irgendwann ja. Wir nennen es Konnektom – also die Gesamtheit aller Nervenzellen und ihrer synaptischen Verknüpfungen im Gehirn.

Wie weit ist man schon?

Zugebenermaßen noch ziemlich am Anfang. Wir sind schon sehr stolz, dass wir Gewebestücke mit mehr als 10.000 Zellen kartieren können. Das sind bereits große Fortschritte in Vergleich zu den letzten Jahren. Dennoch ist es natürlich nur ein Bruchteil der gesamten Menge an Nervenzellen, die im Gehirn steckt. Aber auch jetzt bekommen wir schon neuronale Kommunikationskarten, in denen wir die Nervenzellen-Schaltkreise analysieren könnten.

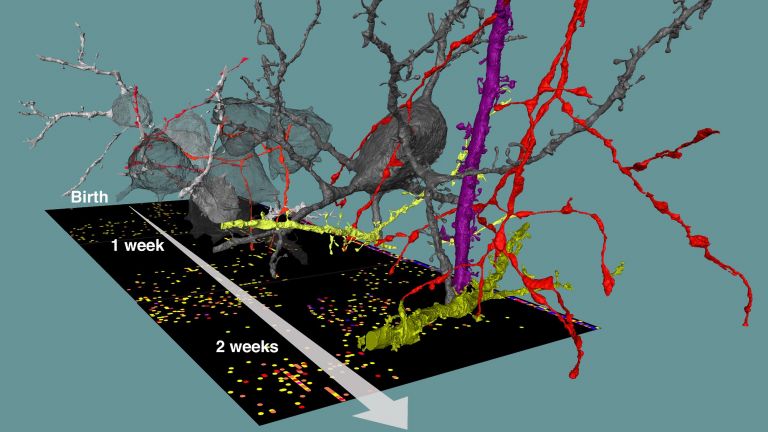

Was möchten sie daraus lernen?

Ich würde sagen, dass es drei wesentliche Bereiche gibt: Erstens wollen wir herausfinden, wo und in welchem Ausmaß Lernen im Gehirn stattfindet. Es ist bekannt, dass Gelerntes sozusagen in den Synapsen gespeichert ist, indem sie die Stärke der Signalweiterleitung verändern. Aber unklar ist, wie diese einzelnen Veränderungen in den Synapsen in ihrer Gesamtheit zu einer Erinnerung führen oder wie wir damit bestimmte Konzepte lernen: Also wie sieht zum Beispiel ein Auto aus?

Und wie sich das dann in den Schaltkreisen manifestiert?

So könnte man es ausdrücken. Als zweites möchten wir verstehen, wie sich das Gehirn Gelerntes zu Nutze macht, um neue Informationen zu verarbeiten. Wir nennen das „Verrechnen“ von neuen Bild- oder sensorischen Daten mit Bekanntem oder Erwartetem. Wie nutzen wir bekannte Modelle für Vorhersagen? Das ist noch unklar. Wir glauben, dass die Schaltkreisanalyse Antworten liefern könnte.

Und der dritte Punkt?

Ein weiteres großes Interesse unserer Forschung besteht darin, in den Schaltkreisen mögliche Veränderungen zu finden, die typisch sind für psychische Erkrankungen. Es wird nämlich schon lange vermutet, dass solche Krankheiten mit veränderten Netzwerkstrukturen des Gehirns einhergehen. Allerdings fehlten uns bisher die Methoden, dies mikroskopisch auch nachzuprüfen.

Könnte Ihre Forschung auch helfen, KI-Anwendungen zu verbessern?

Ob die KI tatsächlich die Erkenntnisse aus der Hirnforschung braucht, um besser zu werden, ist die große Frage. Klar ist, dass die KI in einigen Bereichen noch deutlich „schlechter“ ist als das Gehirn. Sie verbraucht zum Beispiel viel mehr Energie und benötigt unglaublich viele, gut präparierte Daten, um daraus zu lernen und „intelligenter“ zu werden. Im Lernprozess ist das Gehirn flexibler. Wie es jedoch die erstaunlichen Transferleistungen vollbringt, ist vollkommen ungeklärt.

Falls man nun herausfindet, wie effizientes Lernen funktioniert, ließe sich das dann für die KI nutzen?

Ich denke schon, dass wir einen Beitrag leisten könnten, damit die KI zu verbessern. Vielleicht wird es aber auch ganz anders laufen und die KI-Forschung entwickelt selbst ganz andere Ansätze.

Es gibt ja bereits so genannte neuromorphe Rechner, die gewissermaßen nach Art des Gehirns rechnen.

Genau, das wäre quasi eine weitere Möglichkeit des Erkenntnisgewinns aus unserer Forschung neben der abstrakten Frage nach effizientem Lernen. Bisherige KI-Anwendungen laufen ja auf herkömmlichen Siliziumrechnern, bei denen die neuronalen Netze sozusagen nur durch die Software simuliert werden. Die Prozessoren gleichen also dem Gehirn physikalisch in keiner Weise. Das ist bei neuromorphen Rechnern anders – bei ihnen sind etwa Speicher- und Prozessormodule nicht mehr getrennt, sondern wie im Gehirn vereint. Die Frage ist nun, ob es sinnvoll ist, diese Architektur für die KI zu übernehmen.

Was denken Sie?

Es könnte durchaus sein, dass sich nur mit gehirnähnlichen dreidimensionalen Rechnereinheiten, das Lernprinzip des Gehirns nachbauen lässt. Aber das ist alles noch sehr offen; bisherige Ansätze sind zumindest noch nicht so wahnsinnig erfolgreich. Ich bin aber relativ zuversichtlich, dass sich aus der Konnektomforschung einige Ideen extrahieren lassen, um biologische Rechner zu realisieren.

Wie lange wird es denn noch dauern, bis das menschliche Konnektom vollständig vorliegt?

Das lässt sich nicht sagen. Es wird vermutlich noch einige Jahrzehnte dauern. Unser nächstes Etappenziel ist, das Gehirn der Maus komplett zu kartieren. Das wäre der größte jemals aufgenommen Datensatz. Wir sprechen hier von Exabyte – so etwas gibt es bisher noch gar nicht. Das Volumen des Mäusehirns liegt allerdings immer noch etwa um den Faktor 1.000 unter dem des menschlichen Denkorgans. Aus meiner Sicht ist es jedoch noch wichtiger, in den nächsten Jahren Teile von menschlichen oder menschenähnlichen Gehirnen zu analysieren, da uns hier vielleicht überraschende Unterschiede gegenüber der Maus begegnen. Gleichwohl wäre auch das vollständige Konnektom der Maus ein bedeutender Schritt für die Hirnforschung.