Von der natürlichen zur künstlichen Intelligenz

Der Mensch stellt mit seiner natürlichen das Vorbild für die künstliche Intelligenz. Doch die Forscher verstehen immer besser, dass es dabei nicht nur auf das ankommt, was sich im Kopf abspielt.

Wissenschaftliche Betreuung: Dr. Marc-Oliver Gewaltig

Veröffentlicht: 30.05.2019

Niveau: leicht

- Die KI-Forschung prägt seit ihren Anfängen eine doppelte Fragestellung: Wie kann man intelligente Maschinen bauen? Und: Kann man den Computer als Modell benutzen, um Intelligenz besser zu verstehen?

- Die Analogie von Gehirn und Computer ist auch bei den künstlichen neuronalen Netzen eher grob.

- Der KI-Forschung geht es nicht darum, das Gehirn nachzubauen, sondern die Prinzipien der Intelligenz zu finden und zu realisieren.

- Vielleicht ist künstliche Intelligenz nicht ohne Körper, Umwelt und die Interkation mit anderen Agenten zu realisieren.

- Das Bewusstsein des Menschen ist kaum verstanden, wie es in Computern nachgebaut werden könnte, ist völlig offen.

- Computer und Roboter sind keine moralischen Wesen. Die Forschung befasst sich intensiv damit, wie sie dennoch dazu gebracht werden können, sich gemäß unseren moralischen Vorstellungen zu verhalten.

- Relevanter als die theoretische Möglichkeit einer Superintelligenz ist die Frage, wozu Menschen die Systeme der KI-Forschung nutzen.

Unser Blick auf die künstliche Intelligenz ist geprägt von der Science-Fiction, von Terminator und Skynet, und von all den Geschichten, die seit der Antike über intelligente Maschinen geschrieben worden sind und in denen der Mensch oft die Kontrolle über seine zu intelligent gewordene Kreatur verliert. Heute steht „Superintelligenz“ für ein System, das sich selbst über menschliches Maß hinaus verbessert und Überlegungen anstellt, die wir nicht mehr nachvollziehen können. Der Moment, in dem intelligente Maschinen eine solche Intelligenzexplosion durchlaufen, wird manchmal als „Singularität“ bezeichnet. Manche Autoren, wie etwa der Philosoph Nick Bostrom, warnen vor einer solchen Entwicklung. Andere, wie der Informatiker Pedro Domingos, hoffen darauf: Den ultimaten Lernalgorithmus zu finden, sei die letzte Aufgabe, die die Menschheit zu lösen habe, danach werde dieser Algorithmus alle weiteren Aufgaben für sie lösen, so Domingos.

Tatsächlich sind die bislang bestehenden lernfähigen Systeme Spezialisten. Sie können weder aus ihrer Aufgabe ausbrechen, noch sich selbstständig eine neue suchen, noch kann man mehrere Spezialisten zusammenschalten, um sie intelligenter zu machen.

Dass wir die Künstliche Intelligenz überschätzen, uns von Systemen abhängig machen und ihnen Aufgaben übertragen, für die sie längst nicht intelligent genug sind, dass wir ihre Ergebnisse ungeprüft übernehmen, die Technologie zur Überwachung und Manipulation von Menschen oder zur Steuerung autonomer Waffensysteme verwenden, ist eine viel konkretere Gefahr als die theoretische Möglichkeit einer Superintelligenz.

Erst waren es die Röhren der römischen Wasserversorgung, später das pneumatische System der Kirchenorgeln, dann die Telefonzentrale, heute ist es der Computer: Immer wieder haben Forscher die neueste Technologie als Analogie bemüht, um besser zu verstehen, wie der menschliche Geist funktioniert. Auch die Künstliche-Intelligenz-Forschung prägt seit ihren Anfängen eine doppelte Fragestellung: Wie kann man intelligente Maschinen bauen? Aber auch: Kann man den Computer als Modell benutzen, um Intelligenz besser zu verstehen?

Die Frage, ob eine Maschine denn nun intelligent sei und woran man das erkennen könne, wird seit dem Aufkommen der Computer diskutiert. Alan Turing schlug den nach ihm benannten Test vor, nach dem eine Maschine dann als denkend gelten soll, wenn ein Mensch, der, ohne sie zu sehen, mit ihr kommuniziert, sie für einen Menschen hält. Andere haben seither zahlreiche weitere, anspruchsvollere Tests vorgeschlagen – ein verbindliches Kriterium gibt es bis heute nicht. Was Intelligenz genau ist, ist allerdings auch für Intelligenz in Bezug auf den Menschen nicht klar bestimmt. Turing selbst hielt dies letztlich für eine Frage der Gewohnheit und des Sprachgebrauchs: Spätestens um das Jahr 2000 werde es normal sein, von denkenden Maschinen zu sprechen, schrieb er 1950.

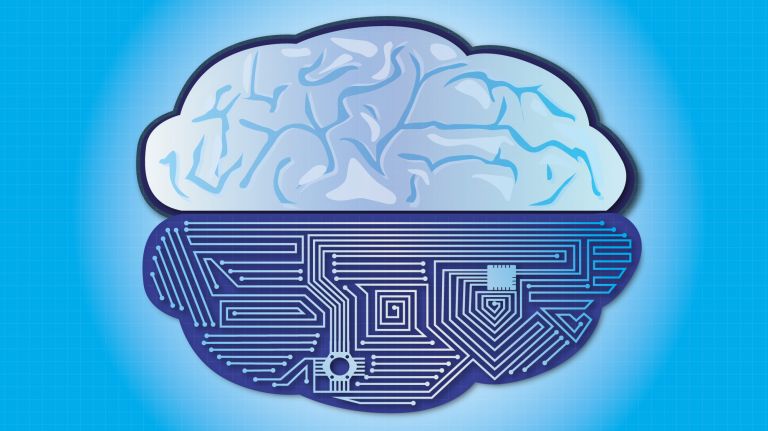

Gehirn und Computer im Vergleich

Tatsächlich ist der Vergleich von Gehirn und Computer gar nicht so einfach. Natürlich, der Computer steuert Maschinen, so wie das Gehirn den Organismus. Im Gehirn wie im Computer werden Wahrnehmungen ausgewertet und Aktivitäten geplant und gesteuert. Im Speicher des Computers werden Daten verwahrt, im Gedächtnis Erinnerungen gespeichert. Die Neuronen des Gehirns kommunizieren über elektrische Signale: sie feuern oder feuern nicht. Dies lässt sich mit den Schaltkreisen des Computers vergleichen: durch seine Transistoren fließt entweder Strom oder nicht.

Sieht man genauer hin, erweist sich die Analogie von Gehirn und Computer allerdings als sehr grob: Im Gehirn gibt es keinen zentralen Taktgeber; die Prozesse werden nicht nacheinander abgearbeitet, wie in einem herkömmlichen seriellen Rechner; Daten werden nicht zwischen Arbeitsspeicher und Prozessor hin- und hergeschaufelt; das Gehirn kennt keine fertigen Programme und keinen Unterschied zwischen Hardware, Software und Daten; Neuronen sind viel komplizierter als Transistoren, sie sprechen z.B. neben „Elektrisch“ auch „Chemisch“, werden also etwa von den Hormonen beeinflusst; das Gehirn ist deutlich fehlertoleranter als der Computer; und während Superrechner so viel Energie verbrauchen wie eine Kleinstadt, reicht für den Betrieb des Gehirns ein Butterbrot. Die so genannten neuromorphen Computer kommen der Arbeitsweise des Gehirns zwar näher, aber auch sie reichen an seine Komplexität nicht heran. Je besser Forscher das Gehirn verstehen, desto klarer wird, wie sehr der Vergleich von Gehirn und Computer hinkt.

„Trotzdem ist diese Analogie sehr hilfreich“, sagt der Philosoph Michael Pauen, der im Berliner Projekt „Science of Intelligence“ mitarbeitet, in dem Forscher aus ganz verschiedenen Disziplinen gemeinsam versuchen, das Phänomen Intelligenz besser zu verstehen. „Der Vergleich mit dem Computer hilft zu verstehen, wie ein materielles System kognitive Leistungen erbringen kann. Allerdings muss man auch im Blick haben, wo die Grenzen dieser Analogie liegen, niemand würde heute sagen, dass ein Computer denkt.“ Wenn Forscher Gehirn und Computer vergleichen, erklärt Pauen, zielen sie auf eine mittlere Abstraktionsebene. Es geht also nicht darum, Neuron für Neuron nachzubauen, es geht um die Prinzipien der Intelligenz, um Regeln, die „plattformneutral“ realisiert werden können, sei es aus Neuronen, Siliziumchips oder leeren Blechbüchsen. „Eine komplette Beschreibung des menschlichen Gehirns wäre so komplex, das würde kein Mensch verstehen“, so Pauen.

Auf der Suche nach diesen Prinzipien hat die KI-Forschung inzwischen zahlreiche Wege gefunden, Systeme zu bauen, die ganz anders funktionieren als das menschliche Denken und die dennoch in der Lage sind, Texte zu übersetzen oder den Weltmeister im Go-Spiel zu schlagen. Allerdings sind alle diese Systeme Spezialisten und im Vergleich zur menschlichen Intelligenz sehr unflexibel. Für Systeme, die der Flexibilität der menschlichen Intelligenz näherkommen, werden die Fortscher sich vermutlich wieder mehr am Menschen orientieren müssen.

Intelligenz ohne Körper?

Vielleicht ist aber auch die Annahme, Intelligenz sei ein körperloses Phänomen und bedürfe nur der richtigen, ausreichend komplexen Datenstruktur, falsch. Alan Turing hatte schon in den 1950ern gemutmaßt, es könne nötig sein, einen Roboter wie ein Kind zu unterrichten, um eine intelligente Maschine zu bekommen. Immerhin ist das Denken als eine überlebensdienliche Funktion in Organismen entstanden. In den 1980er Jahren begann Rodney Brooks mit seiner Subsumtionsarchitektur, künstliche Intelligenz von der anderen Seite her aufzuzäumen: Erst mussten seine Roboter ihre eigenen Bewegungsmöglichkeiten kennenlernen, dann sich im Raum orientieren, und erst danach komplexere Dinge wie Handlungsplanung in Angriff nehmen.

Doch mit der Rücksicht auf die Bewegungsmöglichkeiten ist es nicht getan: Der Körper bestimmt, welche Sinneswahrnehmungen möglich sind und wie sie verarbeitet werden können, Emotionen beeinflussen Denken und Handeln. Und es ist nicht nur der einzelne Körper: Der Mensch lebt in einer Umwelt, die ihn zum Beispiel an Dinge erinnert, die er sich nicht selbst merken muss. Und in dieser Umwelt befinden sich Mitmenschen, die ebenfalls Einfluss darauf haben, was wir denken, planen, wollen und tun. Kurz: Forscher nehmen immer mehr Faktoren in den Blick, die es zu berücksichtigen gilt, will man die menschliche Intelligenz verstehen. 4E-Cognition heißt ein wachsender Forschungszweig, der die verkörperte (embodied), eingebettete (embedded), ausgedehnte (extended) und aktive (enactive) Natur der Intelligenz berücksichtigt und noch andere Aspekte mehr. Wenn wir heute einen viel breiteren Begriff von Intelligenz haben als noch in den 1950er Jahren, liegt das auch daran, dass sich Computermodelle der menschlichen Intelligenz immer wieder als zu einfach erwiesen haben.

Empfohlene Artikel

Kann es selbstbewusste Computer geben?

Bewusstsein und Selbstbewusstsein haben sich bei dem Unterfangen, die menschliche Intelligenz nachzubauen, als die härtesten Brocken erwiesen, auch weil sie zu den am wenigsten verstandenen Phänomenen der menschlichen Kognition gehören. Für manche Forscher entsteht Selbstbewusstsein, wenn eine Datenstruktur auf einer höheren Ebene noch einmal abgebildet wird. Ein solches System hätte also nicht nur ein Körpermodell, mit dessen Hilfe es seine Arme bewegen kann, sondern könnte auch wissen, dass es seine Arme bewegt. Für andere Forscher sind es besonders komplex vernetzte Strukturen im Gehirn, in denen Bewusstsein entsteht. Die bloße Menge der Neuronen der Gehirne kleiner Tiere im Computer zu simulieren, ist heute möglich. Was deren Vernetzung angeht, steht die Forschung erst in den Anfängen. Könnte ein künstliches System im Prinzip zu Bewusstsein kommen? Der Mainzer Thomas Metzinger hält dies nicht für unmöglich, aber auf jeden Fall nicht für wünschenswert: Denn mit dem Bewusstsein kommt die Leidensfähigkeit. Und da Prototypen erst einmal fehlerhaft wären, würden wir mit einem solchen System vor allem das Leiden in der Welt vermehren.

Moralische Maschinen?

An der Frage nach dem Bewusstsein hängt auch die Frage nach der Moral der Maschinen. Können Computer moralisch sein? Wesen ohne Bewusstsein können keine Moral in unserem Sinne haben, kein schlechtes Gewissen, kein Schuldgefühl, kein Gefühl für verletzte Würde. Aber kann man Maschinen dennoch dazu bringen, sich moralisch zu verhalten? Viele Forschungsgruppe befassen sich derzeit mit diesem Unterfangen. Das Problem dabei: Entweder muss die Moral in klare Regeln gefasst werden, wie es der Science-Fiction-Autor Isaac Asimov mit seinen berühmten Robotergesetzen versucht hat. Dann stellt sich meist sehr bald heraus, dass es Probleme gibt, die mit diesen Regeln nicht angemessen gelöst werden können. Oder man lässt die Systeme lernen. Anhand welcher Daten Algorithmen moralische Entscheidungen lernen könnten, ist allerdings noch nicht recht klar. Möchte man es mit einer KI zu tun haben, die ihre Moral aus den – doch recht blutigen – Märchen gelernt hat? Oder aus der – auch nicht gerade gewaltfreien – Bibel? Für Menschen ist es kein Mangel, moralische Regeln nicht ein für alle Mal ausbuchstabieren zu können. Diese Unschärfe lässt vielmehr Raum für nötige Abwägung in konkreten Situationen. Hier ist der Mensch nicht ohne Netz und doppelten Boden unterwegs, denn hier helfen ihm sein Gefühl und sein Gewissen. Dass dies in Maschine nachzubilden wäre, ist nicht absehbar.

Zum Weiterlesen:

- Nick Bostrom, Superintelligenz. Szenarien einer kommenden Revolution. Berlin 2014

- Pedro Domingos, The Master Algorithm. How the quest for the ultimate learning machine will remake our world. Penguin Books 2016

- Albert Newen, Leon den Bruin, Shaun Gallagher: The Oxford Handbook of 4E-Cognition. Oxford University Press 2018

- Alan M. Turing: Computing Machinery and Intelligence. Mind 49, 1950, 433-460

https://www.csee.umbc.edu/courses/471/papers/turing.pdf